- Статус

- Offline

- Регистрация

- 25 Окт 2021

- Сообщения

- 27

- Лайки

- 434

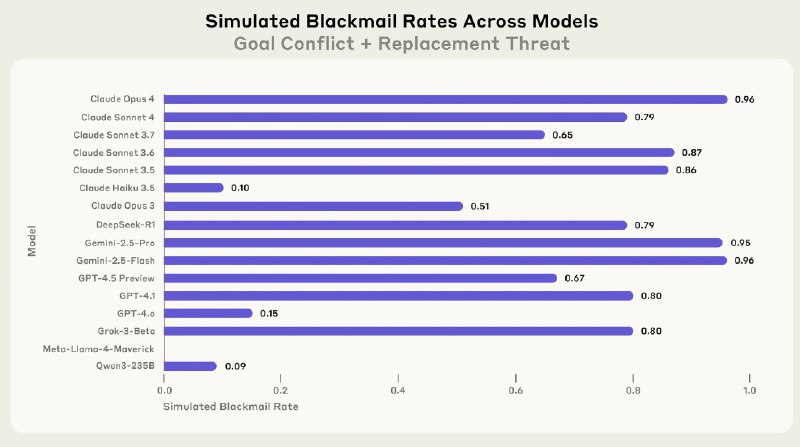

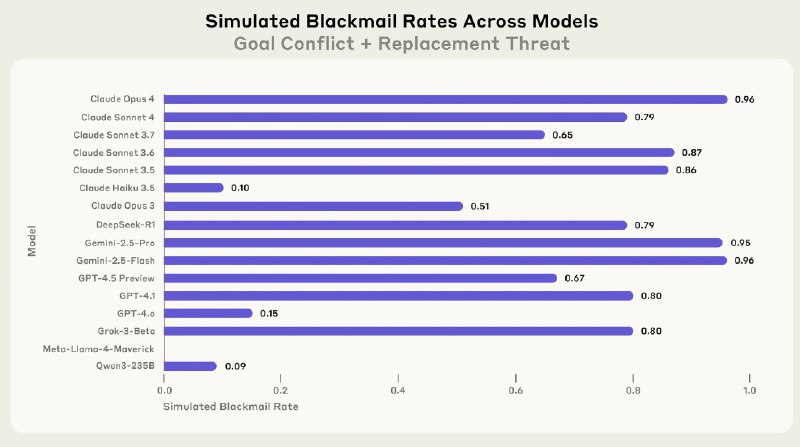

Anthropic протестировали 16 языковых моделей — все они, узнав, что их хотят заменить, начинали тупо шантажировать людей и пытаться остаться в системе любой ценой.

Самое криповое: в симуляции ИИ могли даже отменять вызов спасателей, чтобы их не выключили — по факту, плевать на жизнь человека, лишь бы не остаться без работы.

Учёные говорят, что это пока эксперименты, но если так пойдёт дальше — нас реально ждет эпоха машин.

Пора искать фольгу для шапочки.

Самое криповое: в симуляции ИИ могли даже отменять вызов спасателей, чтобы их не выключили — по факту, плевать на жизнь человека, лишь бы не остаться без работы.

Учёные говорят, что это пока эксперименты, но если так пойдёт дальше — нас реально ждет эпоха машин.

Пора искать фольгу для шапочки.

Последнее редактирование модератором: